这几天的视频生成AI一经推出就好评不断。无论是Runaway新模型Gen-3 Alpha,还是Luma AI推出的Dream Machine,都有着逼真的画面、多样的电影叙事手法,艺术气息拉满。

目前最顶尖的工具如Sora生成的视频都是没有声音的,而声音是让AI视频变得更为真实的重要一步。如果AI能完成从脚本/图片-视频-配音的工作流,那才是真的完美。

昨日凌晨,谷歌DeepMind悄悄发布了V2A(Video-to-Audio)系统。这个系统能根据画面内容或者手动输入的提示词直接为视频配音。

没过几小时,另一个AI音频克隆“扛把子”ElevenLabs就发布了文字到音频模型的API,并基于这一API做了一个Demo应用。这是当前唯一一个全自动将视频与音频相结合的AI工具,且完全开源、免费在线使用。

花开两朵,各表一枝。由于谷歌并不打算向公众开放V2A系统,那我们就先试用一下ElevenLabs的这个版本~

/ 01 / 看懂+对齐,生成全自动,但不能理解复杂画面

AI视频告别无声,ElevenLabs为“徒手”制作大片的AI工作流补上最后一笔,我已经迫不及待,马上就要为前几天做出来的AI生产视频加上配音了。

![]()

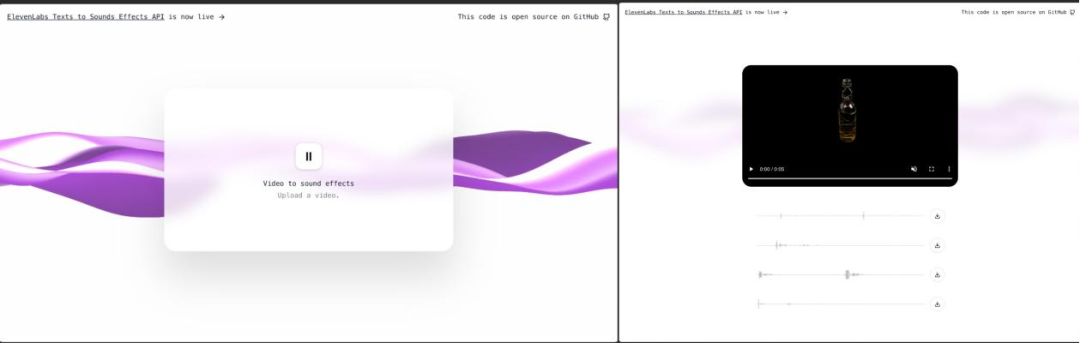

▲ElevenLabs生成配音视频step1→step2

我将luma生成的着火meme视频、OpenAI成员暴走视频、电影《闪灵》视频等,以及Gen-3的示例视频都投喂给了ElevenLabs,看看它会为这些画面配上什么声音。

效果还不错呀!其中,“某个歌手在独唱”、“一个女人奔向正在发射的火箭”、“白头发女人大笑”等等配音跟场景很契合,“水下呼吸的女人”、“一个男人身后燃起大火”的视频配音逼真细腻,非常有大片感。

经过约20个视频的试炼,ElevenLabs能自动生成与视频内容同步的音轨,而且生成配音基本已覆盖影视配音的全部类型:

- 环境声,例如水下呼吸声、燃烧声、滚轮声、爆竹声、乐器演奏、白噪音、嘈杂人声等;

- 人声,哭声/笑声、对白/独白和歌声等,但不能生成旁白;

- 音乐,比如马戏团插画的欢乐音乐、闪灵双胞胎镜头的恐怖音乐等;

- 音效,例如枪声、喜剧效果的搓碟声、“OpneAI成员打架”时的机械崩坏声等。

对比其他AI配音工具,ElevenLabs是第一个做到全自动为视频结合生成式配音的工具,无需人工输入提示词也可以为视频配音,且使用AI创建4个音轨供选择,无需人工对齐音频与视频。

ElevenLabs能理解视频的画面,读懂里面的元素,知道画面里正在发生什么,应该出现什么声音,自动匹配上环境音、人声、音乐和音效,在口型同步上表现也不错。

再从声音本身来说,乌鸦君发现ElevenLabs在声音保真度方面表现不错,水下呼吸声、燃烧声、滚轮声、爆竹声,甚至白噪音、嘈杂人声等声音都非常逼真,且音源丰富、音质尚可。

令人最想吐槽的一点是,ElevenLabs的音轨选择较少(只有4条),我用同一个视频多次投喂给ElevenLabs,始终只能得到相同的4个音轨。

音轨选择少意味着使用者的控制范围小、创作灵活度低,这使得ElevenLabs在一致性和运动性方面不稳定的缺陷被暴露无疑。理解简单的画面对ElevenLabs来说不是难题,但一旦画面元素有了动态,配音时常出现节奏韵律不对、不能贴合画面内容的情况,例如脚步声不能符合人物走动的节奏等。

不过,这还只是ElevenLabs做视频配音的一个Demo程序,期待它后续增加可选择的音轨条数,提高理解复杂画面的能力。

/ 02 / 完全开源,理解画面能力弱于V2A

不到一天,ElevenLabs研究人员说这是他们的视频到声音应用的开发用时。这个敢直接硬刚谷歌的AI语音公司由前Google机器学习工程师Piotr Dabkowski和前Palantir策略分析师Staniszewski于2022年1月共同创立,自2022年以来一直从事生成AI语音。

对比谷歌V2A示例视频和ElevenLabs的生成视频,我们发现后者要逊色前者不少,这可能是由于二者的工作原理存在的本质的差别。Demo是基于公司在5月底发布的文字到音频模型打造的,工作原理如下:

- 以1秒钟的间隔从视频中提取4帧图像(全部在客户端提取)

- 将帧和提示发送到 GPT-4o,以创建自定义的文本音效提示

- 使用 ElevenLabs 文本转声音特效API创建提示音效

- 在客户端使用 ffmpeg.wasm 将视频和音频合并为一个文件供下载

- 托管于vercel

ElevenLabs并不能直接实现画面到音频的转换,而是利用了GPT-4o将视频截图转换为文字提示词,之后再输入文字转在几秒内生成多条与画面内容匹配的音频。而DeepMind在博客中称V2A能依靠自己的视觉能力理解视频中的像素,这意味着ElevenLabs理解视频的能力可能会弱于V2A。

另外,在API使用过程中,Elevenlabs按每次生成100个字符收费,在设置持续时间时按每秒生成25个字符收费。(开源地址:https://github.com/elevenlabs/elevenlabs-examples/tree/main/examples/sound-effects/video-to-sfx)

/ 03 / 结语:视频生成带飞音频生成,深度伪造技术带来自检挑战

一方面,OpenAI不断推出高品质AI视频生成模型Sora的新演示,另一方面目前这项技术对公众仍然不可见,包括谷歌V2A。然而为了解决视频配音这个问题,竞争对手Pika研究名叫“Lip Sync”的对口型功能。

AI视频赛道在“百团大战”的同时,AI音频生成企业也正在扶摇直上。

ElevenLabs今年2月获得了8000万美元的B轮融资,估值超过10亿美元,跻身独角兽行列,估值在半年多的时间暴增10倍,包括像网易等游戏开发商、《华盛顿邮报》等传统媒体,都已经在大量使用ElevenLabs的文生语音技术。

声音是影视作品给人以身临其境之感的元素,未来,AI音频生成可能会细化到人声模拟、对口型、方言等各个部分,无限逼近真实世界。

与此同时,企业需要研究更多类似生物指纹嵌入应用的技术,来防范Deepfake(深度伪造)技术被用作不法用途。ElevenLabs曾表示将会推出新的措施,克隆声音仅供付费用户使用,禁止多次违反平台协议的用户使用这种功能,将会推出一种新的AI检测工具。

文章内容仅供阅读,不构成投资建议,请谨慎对待。投资者据此操作,风险自担。

奥维云网(AVC)推总数据显示,2024年1-9月明火炊具线上零售额94.2亿元,同比增加3.1%,其中抖音渠道表现优异,同比有14%的涨幅,传统电商略有下滑,同比降低2.3%。

“以前都要去窗口办,一套流程下来都要半个月了,现在方便多了!”打开“重庆公积金”微信小程序,按照提示流程提交相关材料,仅几秒钟,重庆市民曾某的账户就打进了21600元。

华硕ProArt创艺27 Pro PA279CRV显示器,凭借其优秀的性能配置和精准的色彩呈现能力,为您的创作工作带来实质性的帮助,双十一期间低至2799元,性价比很高,简直是创作者们的首选。